Sisällysluettelo

AI-agentit, MCP ja lupien siirtovaara: miksi liitännäiset tekevät meistä haavoittuvampia

Perustellakseen keräämänsä törkeän suuret rahasummat tekoäly-yritykset yrittävät vakuuttaa, että niiden chatbotit osaavat paljon muutakin kuin kirjoittaa sähköposteja ja tehdä kissastasi Studio Ghibli -tyylisiä kuvia. Toistaiseksi monet lupaukset ovat joko lässähtäneet tai jääneet kokonaan toteutumatta.

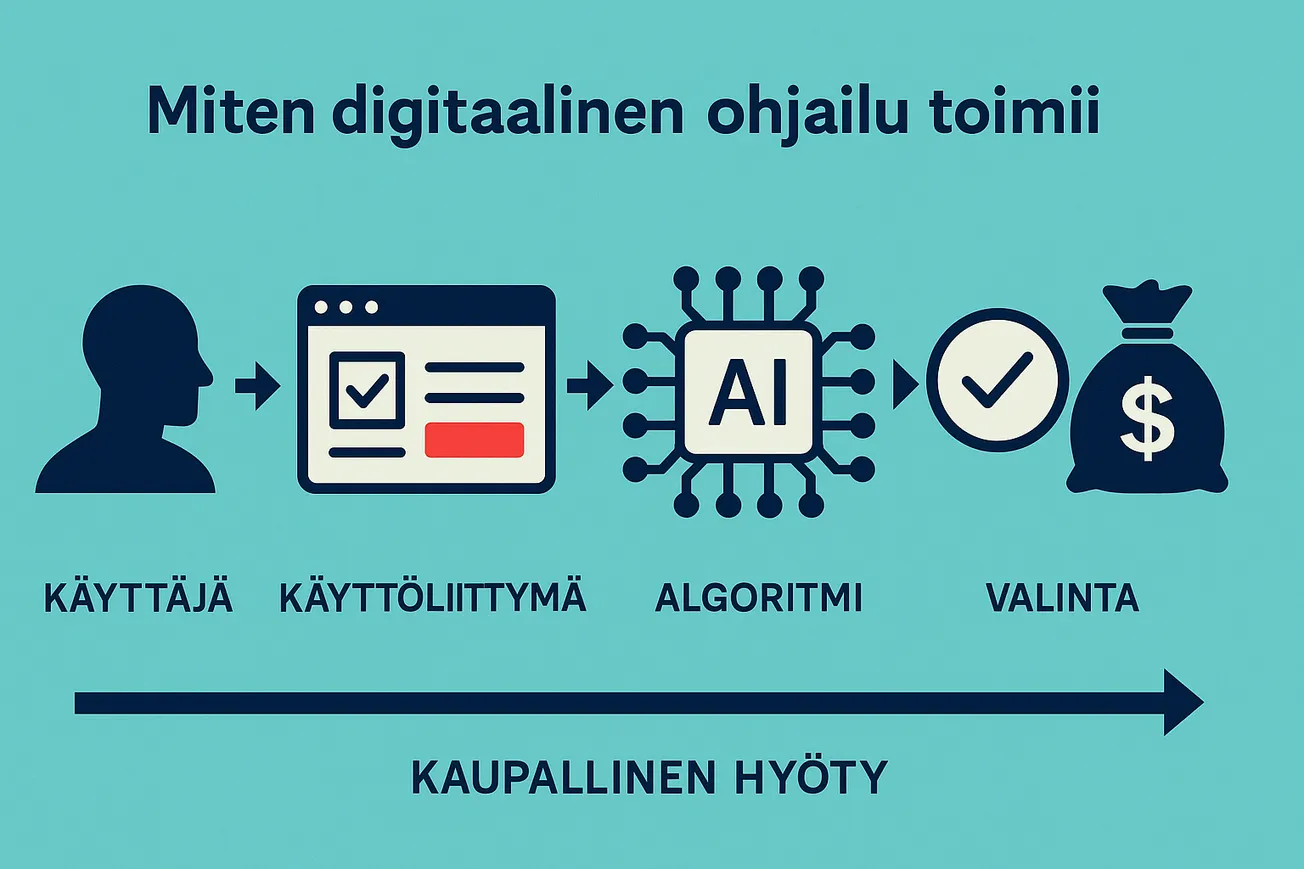

Uusin sijoittajapitch kuuluu näin: nämä työkalut tekevät tehtäviä puolestamme — ja silloin ne ovat korvaamattomia kaikille. Siksi ala on tänä vuonna kääntänyt kurssin kohti tekoälyagentteja: bottien on tarkoitus keskustella muiden palveluiden kanssa ja hoitaa asioita puolestasi.

AI-chatbot + MCP = tekoälyagentti

Yksi innovaatio on herättänyt erityistä huomiota: Model Context Protocol (MCP). Yksinkertaistaen MCP on standardi, joka tarjoaa chatbotille “työkaluja”. Jos haluat botin pääsevän kalenteriisi, pystytät MCP-palvelimen, joka yhdistää kalenteriin ja tarjoaa työkalut kuten ”hae tapahtumat”, ”luo tapahtuma” ja ”muokkaa tapahtumaa”. Vastaavat toiminnot löytyvät monista suosituista tuotteista nimillä connector, liitännäinen tai connected apps.

Teknisesti MCP on napakka tapa standardoida, miten chatbotien kyvykkyyksiä laajennetaan. Se määrittelee työkalut etukäteen ja eriyttää arkaluonteiset tunnistetiedot (kuten kalenteritilin kirjautumiset). Mutta vaikka liitännäiset tekevät boteista hyödyllisempiä, ne kasvattavat samalla yksityisyys- ja tietoturvariskejä.

Käytännössä MCP peilaa perinteisiä API-rajapintoja, mutta mikropalveluarkkitehtuurina: pieniä, liitettäviä moduuleja. Esimerkin kalenterissa MCP pyrkii poistamaan tarpeen koodata erilliset logiikat eri tarjoajille (Outlook, Proton, Google Calendar, Zoom) ja korvaa ne tapahtumapohjaisella käyttäytymisellä. Context streaming auttaa MCP-palvelinta tunnistamaan, miten sovellusta kuuluu käsitellä.

Yhdistäminen ja oikeuksien myöntäminen

Hyvä tapa hahmottaa riskit on ajatella liitännäisiä puhelinsovellusten käyttöoikeuksien ja kolmannen osapuolen palvelujen yhdistelmänä.

- Kuten app-oikeuksissa, käyttäjän on sallittava työkalun käyttö: esimerkiksi ”lue sähköpostit” -työkalu sähköpostiliittimelle.

- Kuten kolmannen osapuolen palvelussa, liitin tarvitsee käytännössä täyden pääsyn yhdistettävään palveluun.

Siksi pääsy syntyy kahdessa vaiheessa:

- Yhdistä tili palveluun.

- Salli käyttö: valitse, mitä työkaluja botti saa käyttää.

Jos olet joskus ihmetellyt, miksi Instagram ehdotti juuri tapaamaasi yhteystietoa — ja muistit antaneesi luvan osoitekirjaan — ymmärrät, miksi tämä herättää huolta.

Useimmat meistä eivät jaksa pyöritellä lupadialogeja. Evästebannerit ovat synnyttäneet suostumusväsymyksen, ja haluamme vain edetä. Silloin on liian helppoa rastia ”salli aina”. Etkö halua yhdistää sähköpostia joka käyttökerralla? Yksi ruksi ratkaisee — ja pääsy jää pysyväksi.

Riskit eivät ole vain entisellään — ne laajenevat

AI-botit voivat olla haitallisempia tietoturvallesi kuin perinteiset sovellukset (ja niissäkin on nähty tarpeeksi ongelmia). Botit ja agentit avaavat uusia hyökkäyspintoja, joita ei vielä kunnolla ymmärretä tai osata torjua: ne voivat sekä käyttää arkaluonteista dataa että levittää pääsyn sitä kehittäneille yrityksille.

Esimerkkejä:

- Google Driveen kanssasi jaettu tiedosto voi manipuloida siihen kytkettyä bottia.

- Haitallinen kalenterikutsu voi prompt injectionin avulla johtaa sähköpostien paljastumiseen, jos liitännäiset yhdistävät Google Kalenterin ja Gmailin.

Ala vastaa usein: ”seuraa bottia käyttöliittymästäsi.” Heikko suunnittelu on jo johtanut noloon lopputulokseen, kuten tapaukseen, jossa jaetun keskustelun virhe paljasti julkisuuteen tuhansia yksityisiä chatteja.

”Seuraa agenttia” ei ole kestävä ratkaisu

Jos aiomme antaa boteille yhä syvemmän pääsyn arkeemme ja dataamme, tarvitsemme enemmän kuin käyttöliittymän vaihtokytkimiä tai piilotettuja varoituksia dokumentaatiossa.

AI-Agentti: ”Ai-Agentti voidaan huijata lähettämään kontekstistaan (esim. kehote, projektit, MCP:n tai Google-integraatioiden kautta saatu data) tietoja pahantahtoisille osapuolille. Riskien lieventämiseksi suosittelemme seuraamaan AI-Agenttia ominaisuuden käytön aikana ja keskeyttämään sen, jos se toimii odottamattomasti.”

ChatGPT: ”ChatGPT-agentissa on useita suojamekanismeja… kuitenkaan riskit eivät poistu. On tärkeää seurata agenttia ja käyttää harkintaa.”

Käyttäjälle sysätty valvontavelvollisuus on ristiriidassa sen lupauksen kanssa, että AI-työkalut hoitavat arjen puolestamme ”vaivattomasti”.

Prompt-injektiot eivät katoa — vastuu on määriteltävä

On epärealistista olettaa, että käyttäjä yksin navigoi ulkoisiin palveluihin kytkeytymisen riskit aikana, jolloin työkaluja markkinoidaan juuri liitäntöjen hyödyillä — usein vielä kirjoitusoikeuksilla ulkoisiin järjestelmiin.

Ennen kuin liitännäisten kirjoitusoikeus myydään ”arjen automaationa”, alan on vastattava: kuka kantaa riskin, kun oikeuksilla tehdään vääriä asioita?

Tämän luulisi olevan itsestään selvää, mutta se on silti sanottava ääneen:

käyttäjien tietoturva ja yksityisyys menevät aina ominaisuuksien edelle. Yksikään rahakilpa ei oikeuta päinvastaista.

Yhteenveto

- MCP standardoi botin työkalut ja erottaa tunnistetiedot, mutta lisää hyökkäyspintaa.

- Liitännäiset toimivat kahdessa vaiheessa: yhdistä tili + myönnä oikeudet.

- Prompt-injektiot ja kontekstin manipulointi ovat todellisia riskejä, jotka ulottuvat kalenterista sähköpostiin ja pilvitiedostoihin.

- Valvonta käyttäjän vastuulla ei riitä: suojausten on oltava oletusarvoisesti vahvoja ja riskinkantajien selkeästi määriteltyjä.